Legge di Moore

Quando si parla della Legge di Moore si allude genericamente al veloce e dirompente progresso della tecnologia informatica. In realtà Moore non si riferiva a tutta la tecnologia ma solo ai microprocessori, le sue leggi sono due, e secondo gli stessi esperti del ramo fra un paio d’anni non saranno più valide.

Gordon Moore è uno dei fondatori della Intel, la produttrice dei processori per personal computer più diffusi al mondo. Nel 1965 osservò che la microelettronica si sviluppava con una velocità esponenziale, e sintetizzò le sue osservazioni nella cosiddetta “prima legge” che porta il suo nome.

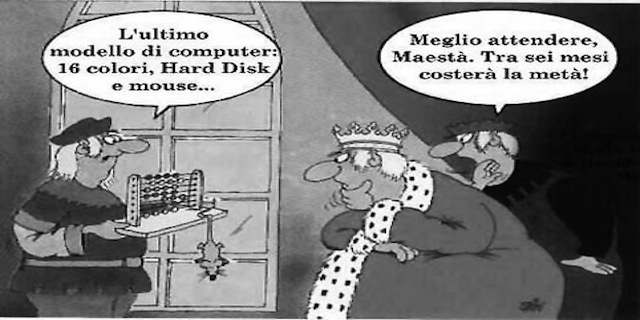

All’incirca ogni 24 mesi, diceva Moore, il numero di transistor di un circuito integrato raddoppia, facendo raddoppiare la performance dei processori ogni 18 mesi. Quando esce un processore nuovo, si deprezzano i precedenti e i costi delle tecnologie calano.

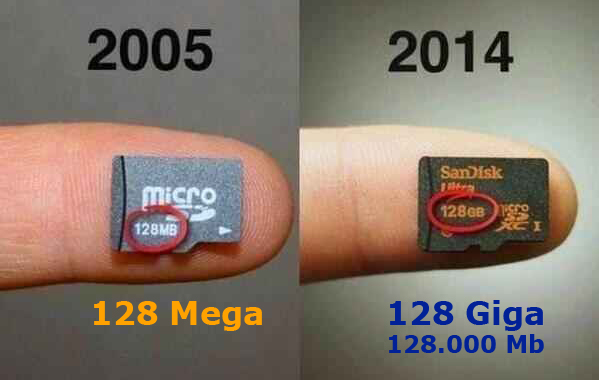

Dagli anni ’60 ai giorni nostri ognuno di noi ha sperimentato l’aumento di prestazioni dei propri computer, insieme con l’abbassamento dei prezzi. Computer, monitor e periferiche che dieci anni fa costavano migliaia di euro oggi costano centinaia o decine di euro e sono enormemente più veloci e potenti. L’immagine mostra l’aumento della capacità di memoria di una scheda SD per notebook in meno di dieci anni.

Lo stesso Moore, e altri esperti della Intel, aggiunsero negli anni ’70 la seconda legge, secondo cui il costo delle apparecchiature per fabbricare semiconduttori raddoppia ogni quattro anni, e il costo di una fabbrica di chip raddoppia da una generazione di prodotto all’altra.

Questi costi crescenti a un ritmo superiore rispetto all’incremento di potenza dei chip fanno aumentare il costo per transistor, riducendo i margini dei nuovi processori. Il prezzo più basso dei processori precedenti impone di utilizzarli in apparecchiature di larga diffusione come elettrodomestici e automobili. Dunque l’investimento per realizzare una nuova tecnologia di microprocessori cresce in maniera esponenziale con il tempo. E altrettanto cresce il rischio di non recuperare i capitali investiti. Per incrementare le prestazioni, occorrono sempre maggiori studi, ricerche e test. Restano in campo poche aziende che tendono ad associarsi per ridurre i rischi di investimenti sbagliati.

Si pensava che la tendenza esponenziale potesse attenuarsi e poi finire solo per i limiti fisici della miniaturizzazione, ma ci si è accorti che il punto critico non è costituito tanto dalle dimensioni del transistor, quanto dalla possibilità di produrre circuiti integrati sempre più complessi e a costi sempre più bassi. I limiti non sono solo fisici, sono anche economici.

Inoltre, l’evoluzione dell’informatica riguarda tutti i settori, non solo i microprocessori. All’aumento della miniaturizzazione e della velocità di calcolo e trasferimento dei dati si aggiungono le architetture hardware e i software che richiedono minori risorse a parità di prestazioni. Anche il tipo di servizi offerti agli utenti ne cambiano le esigenze. Per esempio la crescente diffusione del cloud computing richiede grandi risorse tecnologiche nei server, non nei dispositivi degli utenti, che possono limitarsi al minimo di velocità e potenza che consenta loro di accedere ai dati remoti in qualsiasi momento e da qualsiasi posto.